|

||

咨询QQ: 杂志订阅 杂志订阅 编辑 编辑 网管 网管 培训班 培训班 市场部 市场部 发行部 发行部电话服务:  010-82024984 010-82024984 010-82024981 010-82024981 | ||

|

||

PUE(Power Usage Effectiveness,电能利用效率)是由美国绿色网格组织(TheGreenGrid,TGG)提出的评价数据中心能源效率的指标,因为该指标简单且直接反映数据中心基础设施的能源利用效率,目前已经成为国际上比较通行的能效衡量指标。PUE值是指数据中心消耗的所有能源与IT负载消耗的能源之比。PUE值越接近于1,则表示一个数据中心的绿色化程度越高。

相对应的,评价空调系统的能效可以用空调制冷负载系数CLF(Cooling Load Factor),CLF定义为数据中心中制冷设备耗电与IT设备耗电的比值;评价供电系统的能效可以用供电系统负载系数PLF(Power Load Factor),PLF定义为数据中心中供配电系统耗电与IT设备耗电的比值。

2018年10月,上海市政府发布了信息基础设施的三年行动计划通知,通知中对新建数据中心PUE限制在1.3以下[1]。此文件在当时掀起一阵舆论漩涡,数据中心建设运营方普遍表示此能效指标很难达到。

2019年4月,深圳市发布通知[2],强化节能技术创新支撑作用,采用绿色先进技术提升数据中心能效。文件指出:对于PUE值为1.40以上的数据中心,不给予新增能源消费量替代量支持;对于PUE值低于1.25的数据中心,新增能源消费量可给予实际替代量40%以下的支持。

数据中心采用传统的冷冻水空调系统制冷,在上海PUE是否可以实现1.30,在深圳能否实现1.25PUE?本文将以实际运行的数据中心作为案例进行分析。

一、数据中心总能耗与PUE变化趋势

2010至2020年全球IDC市场规模年复合增长率近20%,快速发展数据中心能源利用也不断攀升,甚至使地区电网供电容量短缺。数据中心的高耗能意味着高碳排放,如何提高数据中心能效水平减少碳排放是我们必须面临的课题,建设绿色数据中心是行业可持续发展的必然道路。

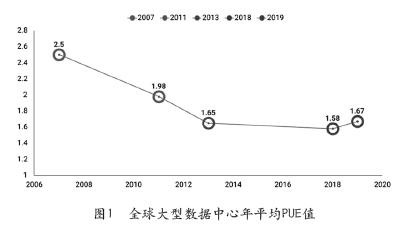

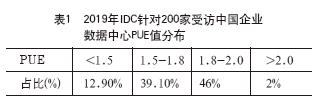

Uptime Institute每年发布的数据中心行业调查报告显示,2007年全球数据中心PUE平均值为2.5,2019年为1.67[3],能效水平显著提升,见图1。根据IDC发布的报告[4],国内大型企业投运的数据中心PUE低于1.5的比例为12.9%,总体能效水平还有很大改善空间,详见表1。

二、数据中心案例介绍

2.1项目概况

(1)项目规模及设计等级

本项目位于北京市,为某云服务商定制化数据中心,钢筋混凝土框架结构。项目分为两个模组,IT机柜功率密度主要容量为7kW和9kW,IT总设计负荷13000kW,市电供电总容量21000kVA。

基础设施按国标A级标准和Uptime标准进行设计建设,供电系统、通信系统为TierⅣ等级,空调系统为TierⅢ等级(内网核心的空调系统达到Tier Ⅳ级别)。

(2)供电方案

IT设备中,网络核心机房IT设备采用双路48V直流电源供电,主机房IT设备采用一路市电和一路240V直流供电。

(3)制冷方案

两个模组设独立的制冷系统,制冷系统采用模组化设计的冷冻水空调系统,具有独立的冷源、蓄冷罐和管道输送系统;辅助区空调采用VRV系统。冷冻水空调系统采用850RT变频离心式冷水机组,3+1冗余运行;冷冻水系统设计为二次泵系统。

模组1空调末端为冷冻水行级制冷机组(InRow),封闭热通道;模组2空调末端为房间级精密空调(CRAH)方案,弥漫式送风、封闭热通道。

2.2 PUE采集位置

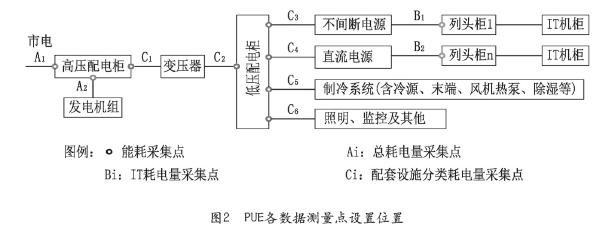

PUE的测量位置和记录数据连续性对结果有很大影响,本案例中总耗电量采集位置为市电进线10kV计量数据(图2计量点A),IT耗电量采集位置为列头柜进线侧(图2计量点B),为便于能效优化,对不同的配套设施的耗电量进行了分类计量(图2计量点C)。

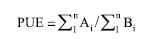

PUE计算方法为:

2.3 模组2实际运行PUE统计

本案例冷冻水行级制冷机组(InRow)模组2018年全年PUE平均值为1.163,在北京区域能效水平领先,单日PUE最高值为1.265。IT负荷率为65%-75%之间,实际运行能效数据统计如表2。

从实际运行统计数据可以看出,冷冻水空调系统综合效率并不是如印象中的低效率,在北京市全年CLF因子可以低于0.09,如果进一步进行精细化管理仍有希望取得更高的能效水平。

项目全年能耗组成结构如图3所示。

由图3可以看出,数据中心除IT以外的能耗中供电系统和制冷系统占比为85%,照明等其他负荷占比仅为15%,对于PUE控制较差的数据中心照明等其他负荷占比更低。所以,数据中心对CLF和PLF的分析尤其重要。

CLF计算方法为:CLF=空调系统总能耗/IT总能耗,本项目中空调系统总能耗包括冷源系统、末端系统、风机热泵、除湿设备以及制冷系统辅助设备的能耗。

PLF计算方法为:PLF=供电系统总能耗/IT总能耗,本项目中供电系统总能耗包括不间断电源、变压器和电源质量治理等设备的能耗。

三、供电系统能效分析

3.1供电系统能耗构成

数据中心主机房每个IT机柜均由两路电源供电,一路为HVDC电源,另一路为市电供电电源,两路电源均分负载。采用市电直供技术和HVDC技术,市电供电效率大幅度提升。HVDC系统在低负载率时可根据负荷情况关断部分功率模块,低负载率时也具有很高的效率。

供电系统全年平均PLF为0.0515,其能耗组成如表3。

从表3可以看出,供电系统耗能比例相对稳定,与季节变化关联性小。

3.2 供电系统能效提升空间

(1)变压器PUE因子提升约0.004

表3中可推算出变压器全年能效平均值为98.73%,与一级能效变压器还有差距。按国标《电力变压器能效限定值及能效等级》(GB20052-2020)的规定,10kV干式变压器I级能效实际工作效率可高于99.2%。采用I级能效变压器,并使其工作在最佳运行负载率区间,变压器效率可提升约0.47%,折合PUE因子提升约0.004。

折合方法说明(下同):

变压器PUE因子=E变压器损耗/EIT耗电量=E变压器损耗/(E总耗电量/PUE)=PUE×E变压器损耗/E总耗电量=PUE×η变压器效率,PUE因子差值即为提升值。

(2)100%市电直供可提升变换设备整体效率可提升至99.5%

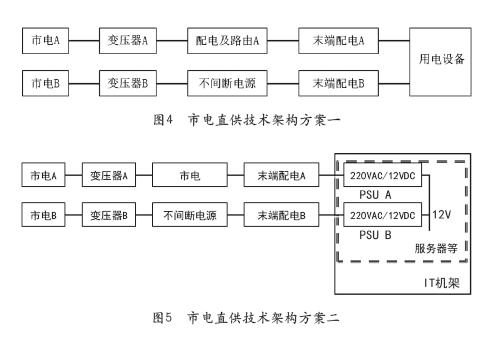

根据表3,HVDC的全年平均效率为(1-0.0236×2)×100%=95.28%,如仍采用HVDC供电,效率提升空间有限。为进一步节能,数据中心IT设备可逐步过渡到100%市电直供,供电技术架构可参考图4和图5。技术方案中不间断电源可以采用UPS供电也可以采用HVDC供电。如采用IT设备采用市电100%供电,不间断电源作为备用,电源变换设备整体效率可提升至99.5%,效率提升4.22%,折合PUE因子提升约0.036。

一路市电和一路HVDC设备联合为IT设备供电时,整流模块可以处于休眠状态以提高系统效率,市电供电回路故障时蓄电池组提供短时紧急供电,30秒内HVDC系统可以启动满载运行。一路市电和一路交流UPS设备联合为IT设备供电时,UPS整流电路可以处于部分休眠状态,蓄电池组通过逆变器提供短时紧急供电,30秒内交流UPS系统可以启动满载运行。

综上,供电系统PUE因子提升空间不低于0.04。

四、暖通系统能效分析

4.1 暖通系统能耗构成

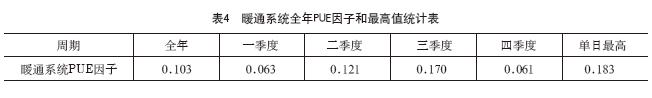

以下分析的是模组1暖通系统PUE因子和能耗结构。冷冻水空调系统采用850RT变频离心式冷水机组,3+1冗余运行,空调末端为冷冻水行级制冷机组(InRow),封闭热通道;冷冻水系统设计为二次泵系统。辅助区空调采用VRV系统。其全年PUE因子和单日最高值统计如表4所示。

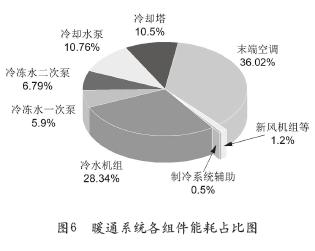

在北京市,不能直接利用自然冷源的情况下,以上运行效率已经非常优秀,达到同纬度区域先进水平。对暖通系统各组建进行能耗分析,可以得到各组件能耗占比如图6所示。

4.2 制冷系统与冷冻水温度的关系

本案例中冷机能耗占比28.34%,低于末端空调36.02%占比,取得了很高的运行能效,主要得益于两方面的措施。

(1)提高冷冻水出水温度PUE因子提升0.08冷水机组不同供水温度直接影响冷机运行效率,

冷水机组的额定工况供回水温度为7℃/12℃;在本案例实际运营中,运维团队大胆突破传统,在保证机房温度可控前提下大胆提升冷冻水供水温度,大幅提升冷机效率;实践中将冷机供回水温度提升至19/26℃,实测冷水机组COP为10.86,较设计参数提升60%。以下为1000RT冷水机组不同供水温度与冷机COP的关系图,见图7。

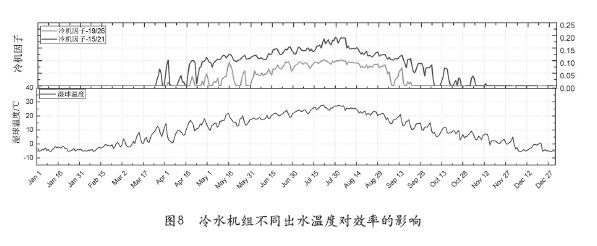

本项目冷冻水送水温度保持在19℃左右,短时间出水最高温度控制在19.5℃以内,在夏季COP也可以保持10以上,从而得到了很好的节能效果。图8是本项目冷水机组PUE因子(上半部青色曲线)与北京另一项目冷水机组PUE因子(上部红色曲线)的对比,下半部为2018年全年北京市湿球温度曲线。从对比曲线可以看出,提高冷水机组出水温度后PUE因子提升了0.08左右。需注意的是上部红色曲线所代表的的项目,因夏季IT负载率整体在40%左右,冷源系统的能效随IT负载率上升,仍有较大的提升空间。故提高冷水机组出水温度后,对PUE因子的影响实际会压缩至0.05左右。

(2)提高自然冷源利用时间

冷水机组供水温度每提升1℃全自然冷源利用时间可以提高200多个小时。因本案例中冷水机组供水温度提升,自然冷源利用时间大大延长,从图8对比可以看出,自然冷源利用时间超过对比项目20%以上,从而最大限度的保持了制冷系统的高效。

空调末端大温差循环提升自然冷源利用时间。目前行业内标准的数据中心供回水温差是5℃,实际运行普遍低于此数值,运维团队通过实践,达到8℃循环温差,较行业标准增加600余小时的自然冷源时间。

(3)水泵、冷机、风机降频、并行

项目团队通过实际运行测试,当电机频率由50Hz降低到25Hz,功耗降低到1/7,节能效益显著。在本项目中普遍使用电机类设备采用变频控制,大大提升了设备运行能效。

4.3 制冷系统能效提升空间

本案例中空调制冷系统采用传统冷冻水空调系统能效水平已经十分优秀,未来能效提升空间有效。进一步提升制冷系统能效主要方向有以下几个方面。

(1)定制高温IT设备

按GB50174-2017的要求,数据中心推荐的冷通道或机柜进风区域的温度为18℃~27℃。为安全考虑,IT机柜租赁方对第三方数据中心服务商提出的SLA中,冷通道温度一般不高于25℃。在送风温度方面还有很大的改进空间,如采用高温服务器运行32℃以上送风温度,则可以进一步提高制冷系统效率。高温服务器受制于IT设备成本和云服务商的积极性,推广难度较大。

以前,云服务商更多从安全运行角度考虑,IT设备对送风温度要求较高,在现有的IT设备基础上尽量提高送风温度也可以很大程度提升制冷系统能效。大量的实际案例说明,进风区域的温度为27℃~28℃,IT设备安全性无明显影响。另外,云计算和虚拟化技术的应用对单个IT设备的可靠性容忍度提升,对设备送风温度的提高也较为有利。

(2)水冷背板空调提高冷机送水温度水冷背板空调靠近热负荷,可提升冷机供水温度1℃以上,但因为存在漏水风险,行业接受度较差难以推广使用。

(3)液冷技术

随着绿色机房概念的提出,节能与环保成为数据中心未来发展的主要技术方向,而如何解决高密度服务器的散热问题成为制约数据中心机房发展的瓶颈。随着相关材料、信号及热交换技术的发展,冷板液冷技术和全浸没式液冷技术得到了很好的发展。液冷技术在超算应用成熟,目前在数据中心主要受限于成本和主设备对液冷方式的支持。

冷板液冷技术制冷PUE因子可以降低到1.08左右,全浸没式液冷技术PUE因子可以降低到1.05以下,制冷系统的能耗将大大降低。

(4)人工智能应用

谷歌成功的将人工智能应用于数据中心的能效管理,每30s就计算一次PUE,还不断跟踪IT设备能耗、机外气温以及制冷和机械设备的设置情况等。对这些数据进一步利用,通过机器学习对这些数据进行研究,并建立起模型来预测并进一步改进数据中心能效。谷歌全球数据中心TTMPUE达到1.1,人工智能功不可没。未来人工智能工具在减少数据中心能耗和浪费方面将发挥着越来越重要的作用,同时可以节约人力成本的投入。

五、结论

北京、上海和深圳湿球温度的最高值分别为31℃、31℃和31.4℃[5],空调系统的制冷效率与空气湿球温度密切相关,供电等其他能耗组成部分与建设地点相关度低。本案例中北京市单日PUE最高值为1.261,意味着数据中心全年均按最高湿球温度运行全年平均PUE应不高于1.27。

从空气湿球温度数据来看,上海和深圳最高湿球温度与北京接近,这意味着在上海建设数据中心采用传统冷冻水空调系统完全可以实现1.30全年平均PUE目标,考虑冬季自然冷源利用、过渡季部分自然冷源利用后,在上海有可能实现全年平均PUE1.20的目标。

深圳全年气温偏高,冬季最高气温也超过25℃,对自然冷源的利用较为不利,如考虑蒸发制冷技术有可能实现全年平均PUE1.25的目标;如考虑冷冻水空调制冷,在采用一路市电+一路不间断电源联合供电且能做好精确送风、精细化控制时,有可能实现全年平均PUE1.25~1.30的目标。

参考文献

[1]《上海市推进新一代信息基础设施建设助力提升城市能级和核心竞争力三年行动计划(2018-2020年)》(沪府办发〔2018〕37号).

[2]《关于数据中心节能审查有关事项的通知》(深发改〔2019〕414号).

[3]《2019年数据中心行业调查报告》,UptimeInstitute.

[4]《2019中国企业绿色计算与可持续发展研究报告》.

[5]空调设计参数选型软件WEATHERDATAVIERERv6.0,SOFTWAREbyASHRAE,2017.

编辑:Harris